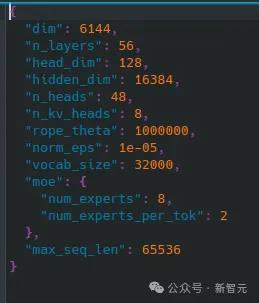

刚刚,Mistral AI又来闷声不响搞事情了!这次他们放出了一条磁力链,里面竟然包含了281.24GB的全新8x22B MOE模型!这个新模型共有56层,48个注意力头,8名专家和2名活跃专家,上下文长度还达到了65k。网友们纷纷表示,Mistral AI一如既往地靠一条磁力链,掀起了AI社区的热潮。贾扬清也表示,他已经迫不及待想看到这个模型和其他SOTA模型的详细对比了!

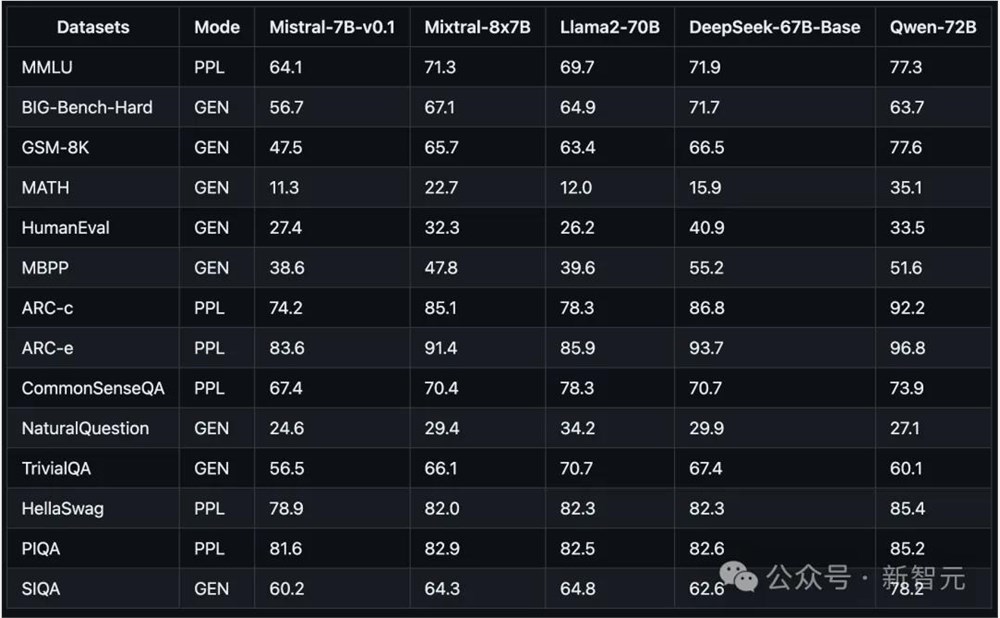

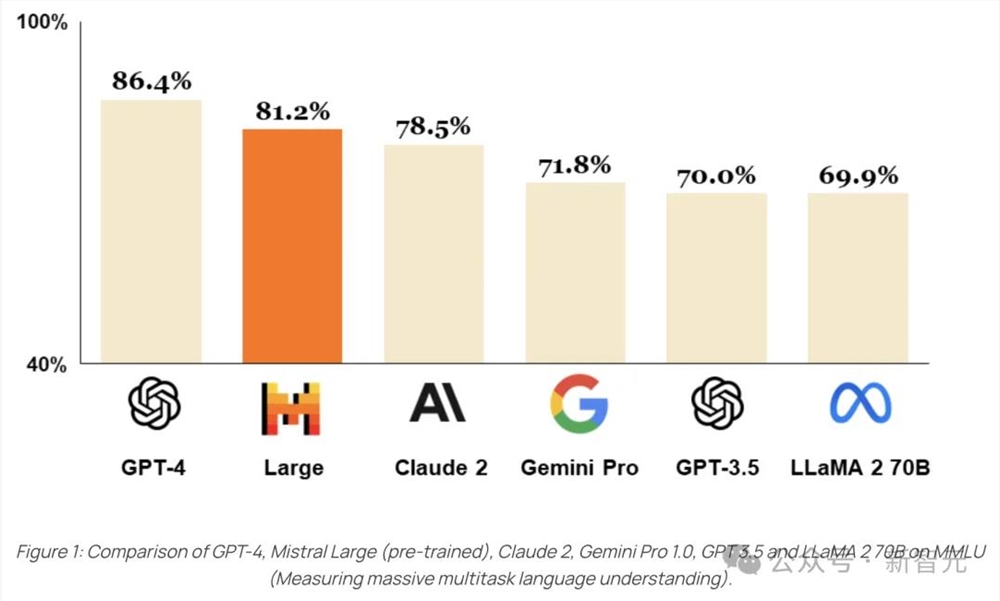

去年12月,Mistral AI发布了首个磁力链,公开了8x7B的MoE模型,收获了不少好评。在基准测试中,这个小模型的性能超越了多达700亿参数的Llama2,可以很好地处理32k长度的上下文,支持多种语言,并在代码生成方面表现出强大的性能。今年2月,Mistral AI推出了最新旗舰版模型Mistral Large,性能直接对标GPT-4,但这个版本的模型并没有开源。

不过,半个月前,在一个Cerebral Valley黑客松活动上,Mistral AI开源了Mistral7B v0.2基础模型,支持32k上下文,没有滑动窗口,Rope Theta =1e6。现在,最新的8x22B MoE模型也在抱抱脸平台上线,社区成员可以基于此构建自己的应用。Mistral AI靠着磁力链已经火遍整个AI社区,让人们对他们的下一步动作充满期待。